Herr Krüger, wie wird Künstliche Intelligenz unsere Gesellschaft und das demokratische Miteinander verändern?

Grundsätzlich sind wir derzeit in einer ähnlichen Situation wie bei der Geburt des Internets. Damals waren viele Menschen unheimlich optimistisch. Sie erhofften sich eine Demokratisierung von Information, weltweiten Austausch, Partizipation für viele, die vorher von Informationen abgeschnitten waren. Und heute? Ist das Internet in Summe ein Wandel zum Schlechteren oder zum Besseren? Schwer zu sagen. Einerseits hat es Informationen zugänglicher gemacht, andererseits ist es zum Geschäft geworden und verbreitet viel Unsinn. Genauso ist es jetzt mit Künstlicher Intelligenz. Einerseits kann sie unsere Demokratie gefährden, weil sie uns etwa mit Deep Fakes manipuliert. Andererseits hat KI ein riesiges Demokratisierungspotenzial. Denn jetzt kommt zu der reinen Information im Internet, den Fakten, noch die Semantik, und damit der Zugang zu echter Bildung, dem Fundament jeder Demokratie.

Das heißt?

Mit Software wie ChatGPT lassen sich Bildungsinhalte auf eine ganz neue Art erschließen: Im direkten Gespräch mit der KI. Sie kann Lerninhalte des Faches Geschichte etwa der sechsten Klasse zusammenfassen und anschließend mit den Schüler:innen darüber diskutieren. Sie müssen nur Fragen stellen, schon kommt das Gespräch in Gang. Es wird nicht mehr lange dauern, bis solche Angebote in großem Stil verfügbar sind.

Aber wie kann ich wissen, wie gut diese Bildung ist? Welche Daten nutzt die KI, um Lerninhalte zusammenzustellen?

Wenn Sie ein Sprachmodell wie ChatGPT zur Geschichte in der Sechsten Klasse fragen, wird es wahrscheinlich auf alle Lehrbücher zurückgreifen, die sonst Lehramtsstudierende in einem Studium verwenden. ChatGPT wurde mit dem Internet bis etwa 2021 und vermutlich auch mit vielen Buchquellen trainiert. Das Modell kommt daher meist zu einigermaßen richtigen Antworten. Allerdings nicht immer, denn im Internet steht auch Quatsch und gerade bei der Interpretation von Geschichte gibt es viele Meinungen. Um gute Bildungsdialoge führen zu können, müsste eine echte Lern-KI daher mit weiteren Bildungsinhalten und Rückmeldungen von Didaktiker:innen trainiert werden. Ein Chatbot-Teacher für Geschichte in der sechsten Klasse wäre dann absolut realistisch.

Nun ist Bildung immer ein diskursiver Prozess. Es gibt oft kein eindeutiges Richtig oder Falsch. Wo liegen die Grenzen einer KI?

In der Tat, wir müssen uns immer klar darüber sein: Ein KI-System versteht nicht, was es zusammenträgt. Es kann also nicht hinter die Inhalte zurücktreten, bewerten, abwägen, hinterfragen. Der US-amerikanische Philosoph Douglas Hofstadter nennt KI „cluelessly clueless“: Sie hat keine Ahnung davon, dass sie ahnungslos ist. Die KI stellt Inhalte nur nach Wahrscheinlichkeiten zusammen. Sie wertet aus Milliarden Daten aus, welche Wörter, Sätze, Argumentationen statistisch am häufigsten vorkommen. Sie scheint intelligent, ist es aber letzlich eher nicht.

Wie könnte KI denn zu echtem Verstehen kommen?

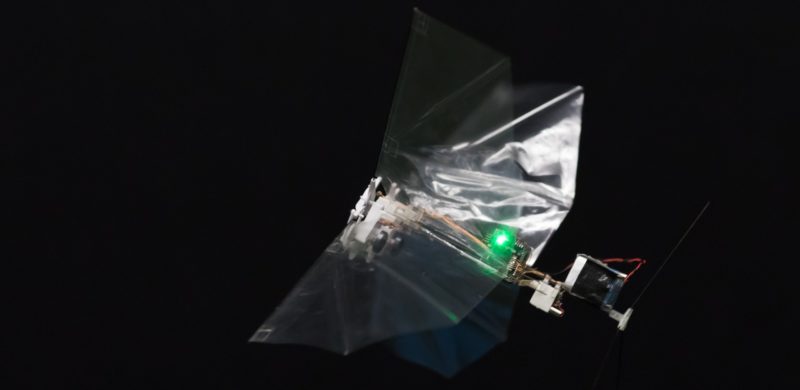

Sie bräuchte dafür eine wirklich tiefe „semantische Repräsentation“ wie wir das in der Wissenschaft nennen. Das heißt, sie müsste selbst Wirklichkeitserfahrungen machen. Denn das ist der wesentliche Unterschied zwischen unseren Gehirnen und den künstlichen Gehirnen, wenn wir sie so nennen wollen: Ihnen fehlt im Moment noch der Bezug zur Realwelt. So gut sie auch sind, sie können derzeit nur abgeleitete Schlussfolgerungen ziehen, die auf den Erfahrungen anderer beruhen. Sie selbst sind gefangen in der digitalen Welt, für sie gibt es kein Außerhalb.

Weil KI schlicht die Körperlichkeit fehlt?

Genau, weil sie noch keine Körperlichkeit hat, keinen Zugang zur Welt da draußen. Es fehlt ihr das „Grounding“, die direkte lebendige Erfahrung der Welt. Eine KI kennt ja nur die Daten, mit denen sie gefüttert wird. Weil ihr der Bezug zur echten Welt fehlt, ist auch ihr Humor nicht besonders gut.

Es gibt Künstliche Intelligenz, die Witze erzählt?

Ja, und meist ist das nicht sehr lustig. Warum können Menschen Witze erzählen? Nicht, weil sie Witzebücher lesen und gelernt haben, wie ein Witz aufgebaut ist. Sondern weil wir beobachten, wie andere Menschen in einer Situation ticken, wie sie reagieren. Weil wir selbst Witze erzählt bekommen. Stück für Stück verstehen wir, was witzig ist, was das mit Situationskomik zu tun hat, mit kulturellen Codes, mit Slapstick. Deshalb sind Kinder meist so schlecht im Witze erzählen, sie stehen noch am Anfang der Wirklichkeitserfahrung, sammeln Erfahrungen. Vieles, das wir über die…

In zwei bis drei Jahren könnte der meiste Content im Internet von einer KI stammen, sagt Antonio Krüger, CEO des Deutschen Forschungszentrums für Künstliche Intelligenz. (Symbolbild)