Herr Gorwa, Sie forschen zu transnationaler Regulierung von Social-Media-Plattformen. Ende 2024 hat Australien ein Social-Media-Verbot für unter 16-Jährige verabschiedet. Begründung: Soziale Netzwerke seien eine zu große Gefahr für die mentale Gesundheit von Jugendlichen. Nach den neusten Ankündigungen von Meta und anderen Techkonzernen, Factchecking und Diversity-Programme zu beenden, frage ich mich: Trifft das nicht für uns alle zu?

Robert Gorwa: Man muss sich stets fragen, ob der Schutz vor negativen Aspekten wie Hetze und Desinformation die positiven Aspekte der Nutzung sozialer Medien überwiegt: die Möglichkeit, mit Andersdenkenden und unseren Freunden zu interagieren. Informationen auszutauschen, auch unter Minderheiten. Ich persönlich glaube das nicht.

In der Tat sagt eine australische NGO für Mental Health, dass über 70 Prozent der australischen Jugendlichen erst über Social Media überhaupt Informationen zu psychischer Gesundheit bekommen und sich zum Beispiel durch Aufklärung dort eine Therapie suchen. Gleichzeitig sagten auch 38 Prozent in der Studie, dass dort eben auch viel gefährlicher Fake-Content lauere.

Digitale Öffentlichkeit ist wie jede Form von Öffentlichkeit auch ein gefährlicher Ort. Noch vor 15 Jahren haben wir die Netzwerke für ihren demokratisierenden Effekt gefeiert, zum Beispiel für ihre Rolle im arabischen Frühling, als sich dort demokratischer Widerstand organisierte. Aber das australische Gesetz ist eben auch Beweis dafür, dass das Pendel heute in die andere extreme Richtung ausgeschlagen hat: Wir haben von Firmen gesteuerte soziale Netzwerke, die auf starke Emotionen und maximalen Profit ausgerichtet sind. Ich denke also, man muss Ihre Frage mit Ja beantworten. Ich glaube aber nicht, dass Verbote wie in Australien die richtige Antwort sind.

Robert Gorwa

forscht am Wissenschaftszentrum Berlin für Sozialforschung zu transnationaler Governance und Regulierung von Social-Media-Plattformen. 2024 ist sein Buch The Politics of Platform Regulation: How GovernmentsShape Online Content Moderation bei Oxford University Press erschienen.

Und was wäre die richtige Antwort?

Der Kulturwissenschaftler Mark Fisher hat gesagt: Es ist einfacher, sich das Ende der Welt vorzustellen, als sich das Ende des Kapitalismus vorzustellen. Ich glaube auch, Ersteres ist heute einfacher geworden, als sich sinnvolle Alternativen zu Facebook, Instagram oder TikTok vorzustellen. Alternativen, die von Menschen für Menschen als Genossenschaft oder in einem anderen Geschäftsmodell betrieben werden, das weniger ausbeuterisch ist. Aber genau diese Vorstellungskraft dürfen wir nicht verlieren. Wir müssen über andere Formen von Social Media Governance und Regulation sprechen.

Sie untersuchen unter anderem auch die Umsetzbarkeit der ursprünglichen Utopie des Internets: ein Ort, an dem sich User:innen selbst regulieren. Glauben Sie angesichts des hohen Grads der Polarisierung in den sozialen Netzwerken noch daran?

Ich denke, wenn wir noch einmal völlig von vorn mit Social Media beginnen könnten, hätten wir eine Chance: Wir sehen Menschen wie Eugen Rochko, der Gründer des deutschen Netzwerks Mastodon, der das Unternehmen in eine Non-Profit-Struktur und in ein dezentrales Netzwerk überführt hat, weil er verhindern will, dass seine Plattform von Firmeninteressen kontrolliert wird. Die Realität ist jedoch, dass wir für eine echte demokratisch regulierte Social-Media-Nutzung ein sehr hohes Level an individueller Partizipation benötigen, die repräsentativ für die Gesellschaft ist. Und dem ist nicht so. Wir haben ein klares Repräsentations-Gap bei Expert:innen für Tech-Themen. Wir sehen an den hohen Überlaufzahlen zu Mastodon und Blue Sky, dass Menschen zwar ein großes Interesse an Netzwerken haben, die nicht von Grund auf „böse“ sind. Aber sie haben nicht den Luxus der Ressourcen, um selbst die Governance zu stellen, die es für diese Utopie benötigt. Die funktioniert im Moment meist nur auf einem sehr lokalen, kleinen Level.

Eine Alternative zur Selbstkontrolle einer digitalen Community ist staatliche Regulation. Sie haben 2024 Ihr erstes Buch veröffentlicht, in dem Sie die Strategien verschiedener Länder dazu analysieren. Können Sie ein Beispiel für eine effektive Methode nennen?

Es ist wichtig festzustellen, dass eine rein staatliche Kontrolle ein zweischneidiges Schwert ist, das zwar gefährliche Inhalte unterdrücken, aber auch demokratischen Austausch verhindern kann. Ein interessantes Beispiel für einen Dialog, der mehrere Stakeholder involviert hat, ist Neuseeland. Nach den Christchurch-Attentaten 2017, die über Facebook-Livevideos verbreitet wurden, holte die Regierung soziale Netzwerke, die Zivilgesellschaft, andere Länder wie Frankreich und Unternehmen wie Microsoft ins Boot, um gemeinsam nach Lösungen zu suchen. Das interessanteste konkrete Ergebnis war, dass das eher unbekannte, aber sehr wichtige Global Internet Forum to Counter Terrorism (GIFCT) 2019 von einer Initiative der sozialen Netzwerke zu einer echten Organisation umgebaut wurde. GIFCTZ baute eine Datenbank für gewalttätige und extremistische Inhalte auf. Durch die Abgleichung mit diesen Daten konnte viel potenziell gefährliches Material auf sozialen Netzwerken identifiziert werden.

Damals wollte Meta noch ein Vorreiter im Kampf gegen Hass und Gewalt im Netz sein. Jetzt erlauben soziale Netzwerke wieder Hetzrede gegen Frauen, Transpersonen und Migrant:innen.

Eines der Probleme ist, dass das Engagement gegen Extremismus für soziale Netzwerke in den USA im Gegensatz zu kinderpornografischen Inhalten nur freiwillig ist. Es hat sich herausgestellt, dass Meta solche Inhalte nicht mehr so stark bekämpft. Hier sehen wir auch das Problem der Transparenz. Wie werden problematische Inhalte von wem selektiert? Wir haben am Beispiel des Nahost-Konflikts gesehen, wie Benjamin Netanjahu Mark Zuckerberg angerufen hat, um sich über die Regulierung auf Facebook zu beschweren. Gleichzeitig ergaben mehrere Recherchen von Medien und Menschenrechtsorganisationen, dass Facebook und Instagram die Reichweite palästinensischer Medien stark eingeschränkt haben. Die interne Regulation der Plattformen ist oft eine Blackbox.

Wie können wir in Europa gegen die Netzwerke vorgehen? Im Moment reagiert die EU nur mit Bußgeldern. Aber was interessieren ein paar hundert Millionen eini…

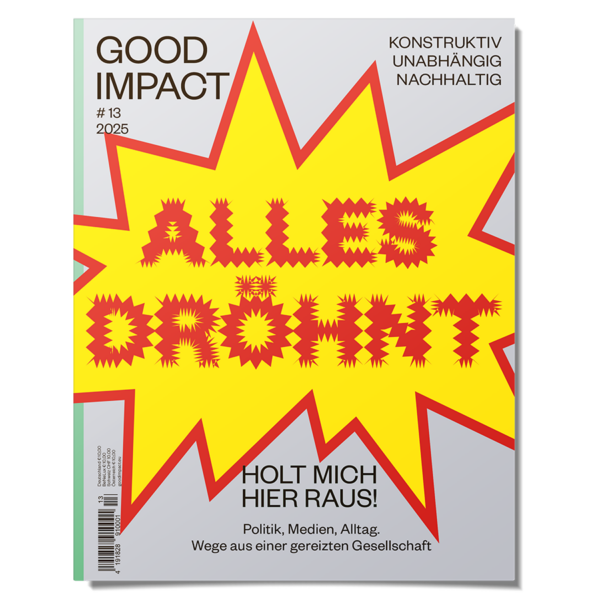

Social-Media-Geklapper voller Fake-Content von morgens bis abends: Braucht es strengere Regeln für den digitalen Raum?